KI-Anwendungen sind längst Bestandteil der medizinischen Versorgung. Dabei erleichtert der KI-Generator bei weitem nicht nur das Arztbriefschreiben: Bei der Früherkennung verschiedener Krebsarten beispielsweise helfen neuronale Netzwerke beim Auswerten der radiologischen Diagnostik, oder die KI unterstützt die Früherkennung anderer Krankheiten mittels spezieller Apps.

Es sind Aufgaben, die Ärztinnen und Ärzte in einer jahrelangen Ausbildung gelernt haben und Künstliche Intelligenz nun genauso gut erledigen soll. Es gibt inzwischen auch viele Studien zu den vielversprechenden Fähigkeiten der Technologie.

Doch: Wer als Arzt mit KI arbeitet, wird von Patient:innen als schlechter eingeschätzt, das haben Psychologinnen und Psychologen der Universität Würzburg und der Charité Berlin nun in einer Studie herausgefunden.

Als weniger kompetent, vertrauenswürdig und empathisch werden demnach Mediziner beurteilt, die angeben, KI in ihrer Arbeit zu verwenden. Solche Vorbehalte zeigten sich sogar dann, wenn die KI gar nicht für Diagnose- oder Therapiezwecke eingesetzt wird, sondern für administrative Aufgaben.

In unserer Rubrik „3 auf 1“ wollten wir deshalb von Expert:innen wissen: Schadet KI dem Arzt-Patienten-Verhältnis? Und wie kann das verhindert werden?

KI darf im Klinikalltag keine Blackbox sein

Stefanie Speidel ist Professorin für Translationale Chirurgische Onkologie, Nationales Centrum für Tumorerkrankungen Dresden (NCT). Sie sagt: Wenn Ärzt:innen und Patient:innen an der Entwicklung beteiligt seien, stiegen Akzeptanz wie Sicherheit im Umgang mit KI.

Nicht zwangsläufig schadet Künstliche Intelligenz dem Vertrauen zwischen Ärzt:innen und Patient:innen – KI kann sogar dazu beitragen, dass sich das Verhältnis verbessert, indem sie beispielsweise repetitive Aufgaben übernimmt oder vorab personalisierte Therapievorschläge erstellt.

So bleibt mehr Zeit für die Patient:innen. Es geht ja nicht darum, die Ärzt:innen zu ersetzen, sondern zu unterstützen. Entscheidend dafür ist aber Transparenz, Erklärbarkeit, rechtliche Verlässlichkeit sowie eine partizipative Entwicklung.

Im Klinikalltag darf die KI keine Blackbox sein – Ärzt:innen müssen nachvollziehen können, warum sie etwas vorschlägt. Erklärbare KI hilft dabei, zum Beispiel durch visuelle Hervorhebungen, kurze Begründungen oder Angabe von Unsicherheiten.

Auch beim Datenschutz ist Vertrauen wichtig: Patient:innen müssen wissen, was mit ihren Daten passiert – und zustimmen können. Zum Einsatz kommen sollten nur zertifizierte Systeme, deren Nutzen durch Studien belegt ist.

Die letzte Verantwortung liegt immer bei den Ärzt:innen. Wenn Ärzt:innen und Patient:innen an der Entwicklung beteiligt werden und die richtigen Schulungen angeboten werden, steigt nicht nur die Akzeptanz – sondern auch die Sicherheit im Umgang mit KI.

An KI als wichtiger Modernisierungsschritt führt kein Weg vorbei

Marie Zahout ist Redakteurin beim Tagesspiegel Background Gesundheit & E-Health. Sie sagt: Reale Ängste wie vor einem Kontrollverlust müssten ernst genommen, aber in Kontext gesetzt werden – wobei geschulte Fachkräfte helfen.

Künstliche Intelligenz wird weder Todkranke heilen, noch die Ärztin oder den Arzt ersetzen. Für Patientinnen und Patienten ist es vor allem wichtig, zu verstehen, was KI ist – nämlich ein Werkzeug. Und als dieses muss der Einsatz auch transparent kommuniziert werden.

Ebenfalls wichtig zu erklären ist, dass beim Schreiben von Arztbriefen oder der Analyse von Röntgenaufnahmen kein Weg an dem Modernisierungsschritt vorbeiführt. Denn KI kann Gesundheitspersonal entlasten, administrative Aufgaben abnehmen und bei der Diagnosestellung helfen.

Insofern ist es aktuell Aufgabe von Medizinerinnen und Medizinern, den Technikeinsatz knapp und sachlich zu erwähnen und Fragen zu beantworten. Reale Ängste wie vor einem Kontrollverlust müssen ernst genommen, aber in Kontext gesetzt werden. Wobei an dieser Stelle geschulte Fachkräfte helfen könnten.

Ein weiterer Rahmen, der für Sicherheit bei Patientinnen und Patienten sorgen kann, sind gesetzliche Regelungen, die es teilweise bereits gibt. Wichtig ist hier aber sicherlich neben einem Nachweis der Wirksamkeit auch, dass das Verhalten oder eine mögliche Voreingenommenheit des KI-Produkts verstanden wird.

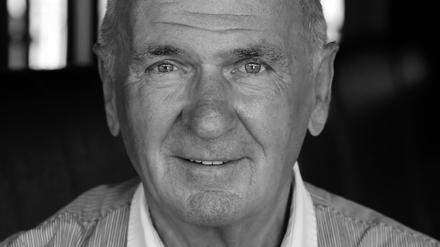

Die Systeme sind nicht wirklich intelligent

Christian Ledig ist Inhaber des Lehrstuhls für Erklärbares Maschinelles Lernen an der Otto-Friedrich-Universität Bamberg. Er sagt: KI bringe zwar Herausforderungen mit sich, doch in der Bevölkerung sollten jetzt keine Ängste vor autonomen Systemen geschürt werden.

Um Akzeptanz bei Patienten zu schaffen, ist gute Kommunikation essenziell. KI-Systeme haben hier enormes Potenzial. So kann eine quantitative und objektive Bewertung von Daten sowohl die Arzt-Patienten-Kommunikation als auch die Diagnose verbessern.

Die Systeme, über die wir reden, sind nicht wirklich intelligent. Sie erkennen nur sehr gut Muster. Auch wenn KI als Systemtechnologie viele Herausforderungen bringt, sollten in der Bevölkerung keine Ängste vor autonomen Systemen geschürt werden.

Die Forschung ist weit entfernt von Technologien, die menschenähnliche Intelligenz verkörpern. Wird das undifferenziert kommuniziert, trauen sich Menschen unter Umständen nicht, funktionierende Systeme zu nutzen.

Wichtig ist, dass System und Mensch gemeinsam weniger Fehler machen. Als Argument gegen KI-Systeme wird gerne angeführt, dass es schwer nachvollziehbar ist, wie die KI zu Entscheidungen kommt – eine schwierige Sichtweise. Erklärbarkeit ist für die Kommunikation wichtig, aber für einen statistischen Mehrwert nicht zwingend notwendig. Wie das sehr wirkungsvolle Medikament Paracetamol funktioniert, ist auch noch nicht abschließend geklärt.