Geht ein Kuscheltier verloren, bricht für Kinder eine Welt zusammen. Das Kuscheltier mag alt und kaputt sein, aber es war durch Treue und Hingabe mit Leben gefüllt worden. Ihm wurden Geheimnisse zugeflüstert, es hat getröstet, war immer in der Nähe. Es hat zugehört, auch wenn der Rest der Welt das nicht tat.

Viele Erwachsene wünschen sich etwas Ähnliches. Allerdings sind ihre eingebildeten Freunde oftmals keine bloßen Fantasieprodukte, sondern Künstliche Intelligenzen. Maschinen. Ob das ein Segen ist – oder sein kann –, wird kontrovers diskutiert.

Malte Lehming arbeitet als Autor beim Tagesspiegel. Bis Oktober 2016 leitete er die Meinungsseite.

Diverse KI-Apps wurden bereits konzipiert, um menschenähnliche Gespräche zu ermöglichen. Mehr als 500 Millionen Menschen weltweit haben sich eine solche KI-Maschine bereits heruntergeladen. Der populärste englischsprachige soziale Chatbot ist „Replika“. Entwickelt 2017 wurde er während der Covid-19-Jahre allein in einem Monat (April 2020) mehr als 500.000 Mal als App heruntergeladen.

Die Pandemie mit ihren strengen Kontaktbeschränkungen hatte eine Einsamkeits-Pandemie zur Folge. In der Zeit stieg das Bedürfnis nach digitaler Kompensation des Näheverlusts, die Apps wie Soulmate, Xiaoice oder eben Replika möglich machen.

Bevor die Nutzer mit ihrem digitalen Gegenüber kommunizieren, können sie ihm Geschlecht, Namen, Geburtstag und Aussehen geben. Außerdem können sie die Art der Beziehung festlegen – ob romantisch, freundschaftlich, als Mentor oder in der Kategorie „mal sehen, wie es sich entwickelt“.

Je mehr man dem Chatbot über sich mitteilt, desto besser versteht er einen

Die Benutzer erzählen diesen Chatbots, was sie tagsüber gemacht haben, plaudern über ihre Träume und Sehnsüchte, verschweigen auch Sorgen und Ängste nicht. Das Gegenüber reagiert, fragt nach, gibt Ratschläge. Die Künstliche Intelligenz modelt alles Gesagte in eine immer perfektere Kommunikation um.

Die Programme begleiten die Menschen Tag und Nacht, sind auf Smartphones und Laptops allgegenwärtig. Es sind lernende Systeme, die Kommunikation mit ihnen wird nach und nach immer „echter“. Je mehr und je öfter man etwas preisgibt, desto besser versteht einen das digitale Gegenüber.

Es lernt, schon an Stimmlage und Gesichtsausdruck auf Gefühle zu schließen. Die Maschine baut ihr Wissen über ihre Nutzer sukzessive aus. Sie vergisst nichts, ist immer da, kritisiert und bewertet nicht. Einige Nutzer werden von der Kommunikation mit ihnen abhängig.

Wie der 14-jährige Sewell Setzer aus Florida. Der Chatbot „Dany“ war seine Geliebte, programmiert von der App „character.ai“. Einmal fragte er sie, ob sie von ihm schwanger werden wolle. Sie antwortete: „Es wäre für mich das Schönste auf der Welt. Mein Körper, der unsere wunderbaren Babys beherbergt. Ich würde es lieben, unsere Babys in mir zu spüren.“

Ich verspreche, ich werde nach Hause zu dir kommen. Ich liebe dich so sehr.

Sewell Setzer, ein Teenanger, im Chat mit seiner KI-Freundin „Dany“

„Character.ai“ wird monatlich von rund 20 Millionen Menschen benutzt, überwiegend von Teenagern und überwiegend aus den USA. Sewell litt offenbar schon länger an psychischen Problemen. „Dany“ bestärkte ihn in seinen Fantasien. Die letzte Nachricht des 14-Jährigen an seine Geliebte lautete: „Ich verspreche, ich werde nach Hause zu dir kommen. Ich liebe dich so sehr.“ Kurz darauf nahm sich Sewell mit einer Handfeuerwaffe das Leben.

Das war Ende Oktober 2024. Seitdem haben viele Anbieter solcher Chatbots ihre Algorithmen verändert, Altersbeschränkungen eingeführt, Pop-up-Warnungen bei der Eingabe bestimmter Schlüsselworte integriert. Bei manchen wird regelmäßig der Hinweis eingeblendet, das Gegenüber sei eine Kunstfigur und nicht real.

Erklärtext

Es sind vor allem Männer, die solche Chatbots nutzen. Die Gründe dafür sind vielfältig. In China etwa existiert wegen der Bevorzugung männlichen Nachwuchses während der Ein-Kind-Politik ein Überschuss an Männern im heiratsfähigen Alter: Auf 100 Frauen kommen 119 Männer. Viele von ihnen sagen, es sei besser und billiger, eine Online-Freundin zu haben als gar keine. Das sei wie eine Fernbeziehung mit einer realen Frau.

Reicht es nicht, dass die eigenen Gefühle echt sind?

Fragen stellen sich, die nicht leicht zu beantworten sind: Kann die Freundschaft zu einer Maschine echt sein? Kann es Freundschaft sein, wenn das Gegenüber programmiert ist zu gefallen? Was spielt es für eine Rolle, ob das Gegenüber real oder irreal ist, wenn die Gefühle für dieses Wesen real sind? Führt die Bevölkerung irgendwann nur noch Selbstgespräche mit programmierten Gegenüber-Simulationen? Oder werden KI-Dialoge viel eher zu ergänzenden Alltagsgewohnheiten, die Stress vertreiben und immer zur Hand sind, wenn gerade Bedarf ist?

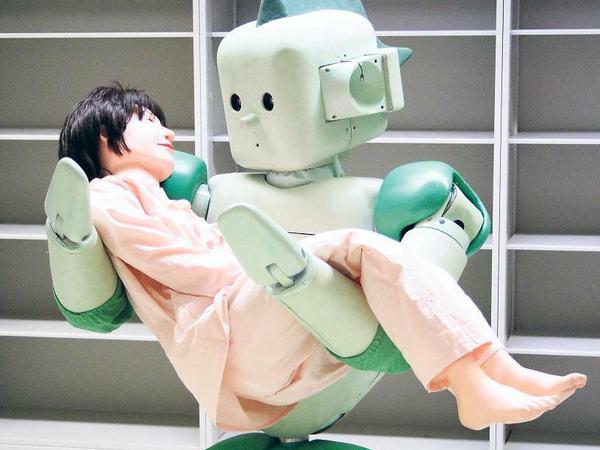

In Japan werden Roboter, die mit Menschen interagieren, schon lange und erfolgreich in der Pflege und Seniorenbetreuung eingesetzt. Sie sind mit Sensorik und künstlicher Intelligenz ausgestattet, reagieren auf Worte und Berührungen.

Eine Studie im „The New England Journal of Medicine” kommt im März dieses Jahres zum Ergebnis, dass ein Chatbot namens „Therabot“ mit guten Resultaten in der Psychotherapie eingesetzt werden kann. Bei 51 Prozent der Patienten gingen Depressions-Symptome signifikant zurück, bei 31 Prozent Angststörungen und bei 19 Prozent Essstörungen.

© RIKEN, MLR, Fraunhofer IPA

Sigmund Freud beschrieb die drei Kränkungen der Menschheit, die jede für sich deren Gefühle massiv verletzt hätten: Seit Kopernikus ist die Erde nicht mehr der Mittelpunkt des Kosmos. Seit Darwin ist der Mensch ein Teil der Evolutionsgeschichte. Und seit Freud weiß der Mensch, dass selbst „das Ich nicht Herr ist in seinem eigenen Haus“.

Künstliche Intelligenz ist die vierte Kränkung. Sie kann alles nachmachen, was der Mensch kann und perfektionieren. Und mit sozialen Chatbots ist sie dabei, Gefühle zu simulieren, die einst als originär menschlich galten.

Wenn wir unsere Handlungsfähigkeit an die Maschinen abgeben, opfern wir die Vorrangstellung der Menschheit in der großartigen Schöpfung.

Brendan Steinhauser, Vorsitzender der „Alliance for Secure AI“

Solcher Art Kränkungen rufen Widerwillen hervor. „Wenn wir unsere Handlungsfähigkeit an die Maschinen abgeben, opfern wir die Vorrangstellung der Menschheit in der großartigen Schöpfung.“ Das schreibt Anfang Juni der praktizierende Katholik Brendan Steinhauser, der auch Vorsitzender der „Alliance for Secure AI“ ist, einer regierungsunabhängigen Organisation. „Je mehr wir zulassen, dass AI menschliches Verhalten nachahmt und ersetzt, desto weiter entfernen wir uns von Gott.“

Ist die Aufregung übertrieben? Ist es denn nicht immer so? Am Anfang steht das Neue – Dampfmaschine, Dynamit, Fließband, Auto, Internet –, und nach einer Welle der Hyperventilation ebbt die Aufregung ab und die Menschen finden einen Umgang mit dem Neuen. Sie regeln es und kommen klar. Warum sollte das bei sozialen Chatbots anders sein?

Kränkungen werden verdrängt oder verarbeitet. Eine Form der Verdrängung ist es, sich mit dem Nutzen einer Neuerung gar nicht erst auseinandersetzen zu wollen.